aspetos teóricos

Notação, conceitos e expressões sobre a regressão linear.

método dos mínimos quadrados

Os estimadores de mínimos quadrados dos coeficientes da reta de regressão são dados por

sendo

e a reta de regressão é então

Note-se que o par \((\bar x, \bar Y)\) pertence à reta de regressão estimada e a segunda equação usa esta propriedade para determina \(\beta_0\).

construção dos estimadores

Por fazer

a fazer a estimação de beta0 beta1 e sigma

Os parâmetros do modelo de regressão linear são estimados através dos mínimos quadrados.

inferência beta0 e beta1

Os parâmetros do modelo de regressão linear são estimados através dos mínimos quadrados.

Os estimadores de mínimos quadrados dos coeficientes da reta de regressão são dados por

sendo

inferência na regressão

Testes e ICs para os coeficientes de regressão Com base em resultados teóricos é possível construir intervalos de confiança e efetuar testes de hipóteses aos parâmetros do modelo de regressão. Esses resultados correspondem ao conhecimento das seguintes distribuições de amostragens:

Os estimadores dos parâmetros e suas propriedades são

podendo assim serem feitos testes como

A tabela de regressão habitual no R contém os testes individuais aos parâmetros $beta_i$:

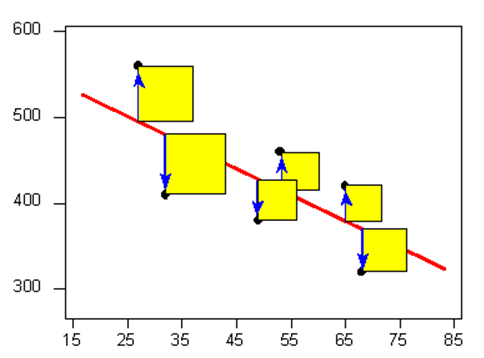

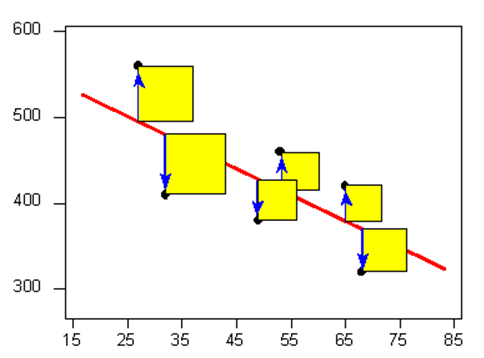

construção do coeficiente \(R^2\)

A variação total \(S_{YY}\) face à média \(\bar Y\) é dada por

e pode ser decomposta nas suas componentes de regressão e erro.

em que:

a variação devido à reta de regressão, \(\hat y|x=\beta_0 + \beta_1 x\), é

(SS quer dizer «sum of squares» e é a notação habitual).

a variação devido aos erros, \((Y|x - \hat y|x) \sim N(0,\sigma^2\), é

coeficiente de determinação

Pode ser calculado com duas interpretações complementares:

\(R^2\) como percentagem explicativa da variação de Y face a x (devida à reta de regressão):

\(R^2\) como (100% - percentagem de variação devida aos erros):

inferência sigma^2

Pretende-se:

construir intervalos de confiança

efetuar testes de hipóteses

ao parâmetro \(\sigma^2\).

Estimação

podendo assim serem feitos testes como

valor esperado

Assim, segue que:

ou ainda

observação futura

(a ser descrito)