homogeneidade de duas variâncias (teste F)

Teste F para a comparação de variâncias \(\sigma_X^2\) e \(\sigma_Y^2\) de duas populações normais independentes.

descrição

A comparação de variâncias \(\sigma_X^2\) e \(\sigma_Y^2\) de duas populações normais independentes é usado em dois testes estatísticos:

realizando um teste bilateral às duas variâncias antes de efetuar o método usado na comparação de médias de duas amostras independentes (t test);

na anova como um teste unilateral à direita.

Assim, parte-se deste pressuposto:

e as hipóteses possíveis são:

homogeneidade de variâncias

Diz-se, na literatura, que «as variâncias são homogéneas» sempre que se efetua um teste às variâncias e não se rejeita \(H_0\,:\,\sigma^2_X = \sigma^2_Y\).

Por outras palavras, variâncias são homogéneas quer dizer, em linguagem não rigorosa que as variâncias das duas populaçõe «são iguais».

pressupostos e validação

Os pressupostos exigidos são:

tem-se duas amostras \(x_1,\ldots,x_n\) e \(y_1,\ldots,y_m\) com dimensões n e m, respectivamente, não necessariamente iguais;

as duas populações devem ser independentes;

as duas populações devem ter distribuição normal.

A validação do pressuposto da normalidade pode ser feita com recurso ao ajustamento à normal.

Notas:

o teste F é muito sensível à violação do pressuposto da normalidade;

se for esse o caso, deve optar-se pelo Teste de Levene (um teste não paramétrico que não está exposto no wiki).

estatística de teste

A estatística do teste F é:

sendo \(F_{(n-1),(m-1)}\) a distribuição F de Fisher com n-1 e m-1 graus de liberdade.

Como \(H_0: \sigma^2_X = \sigma^2_Y\) então a estatística de teste resume-se a

valor observado da estatística de teste

O valor observado da estatística de teste, sob H0,

cálculo do valor-p

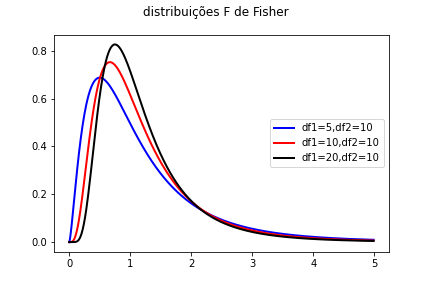

A distribuição F é assimétrica positiva (tornando-se simétrica, em torno de 1, à medida que n e m tendem a infinito).

Para determinar o valor-p bilateral é necessário saber se \(f_{obs}\) é «baixo» ou alto»

valor-p = \(2 \times P(F \le f_{obs} | H0)\) se \(f_{obs}\) é inferior à mediana de \(F_{n,m}\)

valor-p = \(2 \times (1 - P(F \le f_{obs} | H0))\) se \(f_{obs}\) é superior à mediana de \(F_{n,m}\)

Dependendo de n e m, a mediana da distribuição está em 1 ou numa pequena vizinhança de 1. Para valores muito baixos de n e m é melhor calcular a mediana, por exemplo, recorrendo ao R. Por exemplo, a mediana de \(F_{3,10}\) é obtida por

> qf(0.5, df1=3, df2=10) # a mediana pode afastar-se um pouco de 1

[1] 0.8450806

> qf(0.5, df1=10, df2=10) # com n=10 e m=10 graus de liberdade já é 1.

[1] 1

Alternativamente, no teste bilateral, pode-se escolher o menor valor de probabilildade:

não sendo necessário determinar o quantil 50%.

Para os testes unilaterais pode ser necessário determinar o quantil 50%.

R Project

Teste F para a comparação de duas amostras extraídas de populações normais, usando o método do p-value, fornecendo duas amostras independentes, X e Y, de dimensão iguail ou diferente é:

dadosx = c(182.8, 160.9, 166.7, 151.0, 169.0, 169.0, 155.9, 176.6, 154.9, 163.8)

dadosy = c(157.7, 161.0, 152.2, 162.7, 149.5, 146.5, 164.1, 142.8, 157.2, 159.1)

var.test(x = dadosx, y = dadosy, alternative = "two.sided")

O resultado do R é:

F test to compare two variances

data: dadosx and dadosy

F = 1.9021, num df = 9, denom df = 9, p-value = 0.3521

alternative hypothesis: true ratio of variances is not equal to 1

95 percent confidence interval:

0.4724644 7.6580008

sample estimates:

ratio of variances

1.902139

No exemplo, como o valor-p é 0.3521 não temos razões para rejeitar a homogeneidade das variâncias.

texas TI 84

STAT => Test => E: 2 samp F test => stats

Agora, escolhendo «stats» temos:

sx1 = sX corrigido nos apontamentos

n1 = dimensão da amostra X («n» nos apontamentos)

sx2 = sY corrigido nos apontamentos

n2 = dimensão da amostra Y («m» nos apontamentos)

H1: diferente, < ou >

CALCULATE

Output:

H1: sigma1 diferente ou < ou > sigma2

F = \(F_obs\)

p = p-value

Muitas vezes os enunciados omitem o termo «corrigido».

casio FX CG 20

São abordadas as situações: «teste F» ou «Cálculo do valor-p de um teste F»

Teste F

Menu => 2: Estatística => F3: Test => F4: F (test)

Data: escolher «variable»

sigma1 <, diferente, > sigma2

sx1:

n1:

sx2:

n2:

SAVE

Pode ainda escolher «list» se tiver os dados e não tiver os desvios sx1 e sx2.

Calcular o valor-p do teste F

Menu => 2: Estatística => F5: Dist => F4: F

Fcd = cálculo da probabilidade (ou área) em a letra “c” designa “cumulative”;

Data: variable ou list

Lower:

upper: 10^10

n:df = graus de liberdade do numerador

d:df = graus de liberdade do denominador

SAVE

podendo ainda surgir a necessidade de usar:

InvF = dada a probabilidade (i.e., área), obter o quantil (\(F_{obs}\))

mas não será usada

Fpd = densidade de probabilidade.

Ver ainda distribuição F de Fisher para uma exposição mais completa sobre a distribuição F de Fisher.

exemplo completo com calculadora

Considere duas amostras de populações independentes de alturas em cm:

x = 182.8, 160.9, 166.7, 151.0, 169.0, 169.0, 155.9, 176.6, 154.9, 163.8

y = 157.7, 161.0, 152.2, 162.7, 149.5, 146.5, 164.1, 142.8, 157.2, 159.1

Usando o método de ajustamento à normal pode ser testado o ajuste (não feito neste exemplo) e assume-se que X e Y são duas populações normais.

Pretende-se testar se se pode considerar que as variâncias são homogéneas. As etapas são:

populações: descrever as populações e distribuição

Do enunciado,

amostras: introduzir os dados amostrais na calculadora

introduzir as duas listas de valores em L1 e L2 (ou em a[] e b[])

hipóteses: especificar as hipóteses em teste

estatística de teste: especificar a Estatística de Teste

A estatística do teste F é:

pois as amostras são ambas de dimensão 10.

valor-p: cálculo do p-value por uma de duas maneiras

Opção 1 – a calculadora determina o p-value

Fazer o «2 Samp F test»

Opção 2 – usar a calculadora para consultar a distribuição F

obter os desvios amostrais de ambas distribuições:

calcular \(t_{obs}\) com a estatística de teste:

calcular o valor-p bilateral:

como \(f_{obs} > 1\) então o \(f_{obs}\) está do lado direito relativamente à mediana da distribuição F. Assim,

conclusão: conclusão com base no valor-p

Como o valor-p = 0.3522 :math:` > alpha=0.05` então não se rejeita H0, isto é, as variâncias \(\sigma^2_X\) e \(\sigma^2_Y\) são homogéneas, considerando as amostras dadas e nível de significância de 5%.